Ich wollte heute das Compaire-Projekt vorstellen und gar nicht so viel über das Projekt sagen und mehr zeigen, was wir da gemacht haben und hätte den Wunsch, dann auch am Schluss von Ihnen Feedback zu kriegen,

vor allem zu der Art, wie wir das Lernmodul, was aus diesem Compaire-Projekt entstanden ist, umgesetzt haben, gerade wenn Sie auch im didaktischen Bereich tätig sind, sei es als Lehrer oder selber im Bereich Multimedia gearbeitet haben oder selber Umgebungen kennen, in denen Sie selber lernen,

dann wäre es für mich sehr interessant zu hören, ob Sie den Ansatz, den wir da verfolgt haben, sinnvoll finden oder was da zu verbessern wäre.

Aber ganz zu Beginn sage ich ein paar Worte zu dem Compaire-Projekt. Das ist ein Projekt, das ist ein Erasmus Plus Strategic Partnership, das ist ein relativ kleines Projekt,

zusammen mit der Diaske MbH in Hamburg, wo ich beschäftigt bin, und den schwedischen Partnern Funka, die sind sehr bekannt in Schweden, und Braynet in Frankreich.

Das sind alles Organisationen, die sich im Bereich Barrierefreiheit seit Langem bewegen und die in diesem Projekt halt versucht haben, eine Umgebung zu schaffen,

in der Menschen, die die Barrierefreiheit von Web-Anwendungen bewerten sollen, eine Austauschmöglichkeit bekommen. Das war sozusagen der erste Ansatz des Projekts.

Gut, das habe ich schon gesagt. Nach diesen Fakten werde ich dann das Compaire-Verzeichnis, was wir da geschaffen haben, und das Lernmodul kurz zeigen,

und dann hätte ich sozusagen den Wunsch von Ihnen, Feedback zu hören zu diesen Ergebnissen. Die Compaire-Plattform, die ursprüngliche Idee war,

wir testen halt Barrierefreiheit. Ich bin auch jemand, der Aufträge annimmt, oft aus dem öffentlichen Bereich, wo es heißt, okay, wir haben hier eine Website gemacht,

wie barrierefrei ist die denn? Das können Kunden von kleinen Kommunen bis hin zur Bundesregierung, jetzt habe ich gerade die Bundesregierung am Wickel zum Beispiel,

die halt ihr neues Angebot überprüfen lässt, und wo ich dann als jemand, als Tester sagen, Feedback geben soll, was dort zu verbessern wäre.

Und genauso wie ich machen das eine Reihe von anderen Prüfern und Prüfstellen, die den BETV-Test nutzen. Also im BETV-Test-Prüfverbund sind insgesamt

zehn verschiedene Prüfstellen. Das sind zum Teil Verbände der Selbsthilfe, zum Beispiel der Hamburger Blinden- und Seelie-Natten-Verband, das sind einige Firmen,

es sind auch einige Agenturen, die eben auch prüfen und die in diesem Prüfverbund zusammen halt agieren und Aufträge abarbeiten, häufig auch zusammen.

Das einer der Prüfer bei einem Tandem-Test aus der einen Prüfstelle kommt, der andere aus der anderen. Und da entsteht natürlich immer das Problem,

bewertet man dann die Dinge eigentlich auf die gleiche Weise. Also kann der Test von sich behaupten, dass es egal ist, zu welcher Prüfstelle ich hingehe.

Also schafft man es irgendwie, Maßstäbe zu halten über die Zeit hinweg, dass Leute bestimmte Webinhalte nicht völlig unterschiedlich bewerten.

Und der eine sagt, das ist völlig in Ordnung, der andere sagt, nee, das ist überhaupt nicht barrierefrei, das geht gar nicht.

Das war so ein bisschen die Idee. In dem europäischen Kontext kann man das natürlich noch weiterfassen. Da gibt es zum Teil sehr verschiedene Ansätze,

barrierefrei zu bewerten. Also Frankreich zum Beispiel hat ein sehr ausgefeiltes System, wo ganz bestimmte Kriterien der Web Content Accessibility Guidelines

eben auf eine ganz bestimmte Art bewertet werden. Nur als Beispiel, es gibt zum Beispiel eine Anforderung, die für Tastaturnutzer und für blinde Menschen wichtig ist,

dass man die Navigation überspringen kann. Das heißt Bypass Blocks. Das heißt, dass Sie nicht jedes Mal, wenn Sie auf der neuen Seite gehen, durch die ganze Navigation laufen müssen.

Da testen die Franzosen, wenn ich es richtig erinnere, so, dass es sowohl Überschriften geben muss, als auch Sprunglinks, als auch Landmarks.

Es gibt drei verschiedene Wege, um diese Inhalte am Anfang zu überspringen. Nach der französischen Prüfung, wenigstens war es zu dem Zeitpunkt zu, als ich darüber mich ausgetauscht habe

mit einem französischen Kollegen, waren alle drei notwendig. Nach WC-AG wäre eines davon ausreichend. Also die würden zum Beispiel in der Zeit vielleicht schlecht bewerten,

die in einem deutschen Test gut wegkämen. Also die Idee war, all solche Unterschiede eben sichtbar zu machen, indem man eine Plattform schafft, wo man sich austauschen kann,

wo verschiedene Tester und vielleicht auch Entwickler Cases eintragen können, zum Beispiel irgendeine bestimmte Website, wo es einen Karussell gibt oder eine Ausklappnavigation

oder ein anderes Element, dass man das eintragen kann und dass dann verschiedene Tester ihre Bewertung eintragen können mit Kommentaren und dass man dann guckt,

ok, bewerten das denn alle gleich oder nicht? Und wo sind die Unterschiede? Kann man sich da einem Konsens annähern? Gibt es da einen richtig oder falsch?

All solche Fragen werden eben erst bearbeitbar, wenn man überhaupt sieht, wie verschiedene Leute denselben Inhalt bewerten. Das war so die Idee.

Und ich finde, die Idee ist eigentlich auch immer nach wie vor nicht schlecht. Das Problem ist nur, dass es nicht so einfach ist, weil die Leute halt wenig Zeit haben

und weil alle viel zu tun haben und in so eine Umgebung reinzugehen und sich einen Case einzutragen oder einen bereits eingetragenen Case zu bewerten,

halt doch einigen Aufwand bedeutet. Und diesen Aufwand sind viele nicht bereit, auf sich zu nehmen. Deswegen ist dieser Ansatz eigentlich nur sehr mühsam,

hat nur sehr mühsamen Fuß gefasst und es ist schade, aber letztlich auch verständlich, dass es eben nicht so einfach geht.

Man kann nicht einfach sozusagen sagen, los kommt mal alle und bewertet und prüft und tauscht euch aus, weil jeder halt so viel zu tun hat in anderen Plattformen,

in anderen Umgebungen, dass die Zeit dafür am Ende dann nicht da ist. Vielleicht auch der Nutzen dafür nicht groß genug ist.

Also hier wäre zum Beispiel ein Beispiel zu sehen, sind einige Websites, verschiedene Websites mit einer Navigation, die ausklappt,

ein sogenanntes Mega-Menü, wo eben nicht nur eine Reihe von Listenpunkten ausklappt, sondern gleich mehrere Listen ausklappen,

häufig noch mit Zwischenüberschriften und so. Das wäre ein typisches Beispiel, wie bewerte ich sowas, was wäre da richtig, wenn das ausklappt,

wie kann ich damit umgehen, wie gehe ich mit Überschriften in Navigationsstrukturen um und so weiter. Das ist nur ein Beispiel von vielen.

Ja, was machen wir, wenn wir Barrierefreiheit bewerten? Für die, die es nicht wissen, es gibt halt eine Reihe von Werkzeugen,

zum Beispiel die Browser haben bestimmte Toolbars, die man nutzen kann, Web-Developer-Toolbar zum Beispiel, es gibt Bookmarklets,

die bestimmte Dinge hervorheben, zum Beispiel die Struktur, die Auszeichnung, man kann sich über ein Bookmarklet dort,

wo es keine vernünftige Fokushervorhebung gibt, diesen Fokus deutlicher anzeigen lassen und ähnliche Geschichten.

Man kann auch in den Code reingucken, was wir häufig müssen bei den dynamischen Sites, die ja immer komplizierter werden,

und wir werfen auch häufig einen Screenreader an, das ist meistens dann der kostenlose Screenreader NVDA,

um uns einfach mal anzuhören, wie ein Blindenutzer für einen Blindenutzer diese Site erscheint, ob ich daran mich bewegen kann,

ob es verständlich ist, wie die Bedienelemente benannt sind, wenn ich sie erreiche.

Das tun wir natürlich nicht in derselben Qualität wie ein Screenreader Nutzer, der das wie der Marco Zehe jeden Tag benutzt,

Presenters

Detlev Fischer

Detlev Fischer

Zugänglich über

Offener Zugang

Dauer

00:44:52 Min

Aufnahmedatum

2018-09-12

Hochgeladen am

2018-09-12 15:18:22

Sprache

de-DE

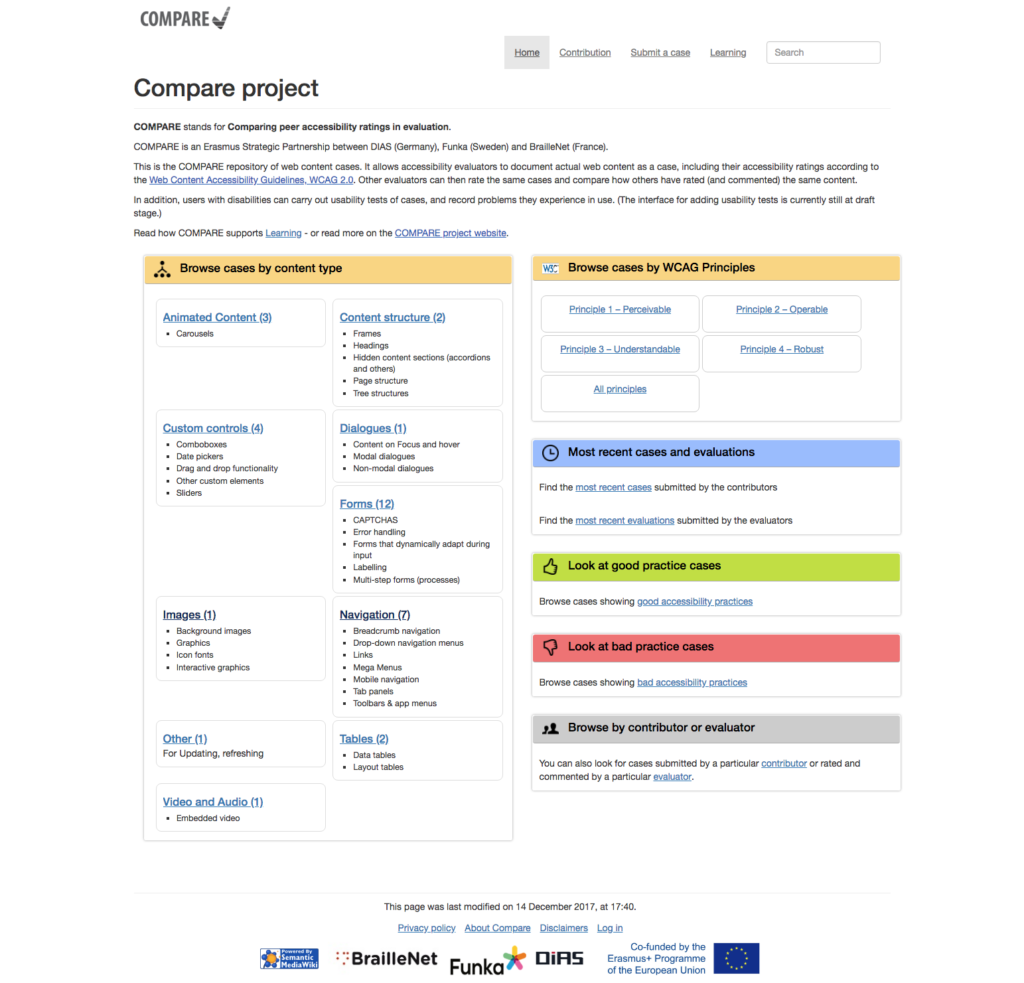

COMPARE ist ein von der EU im Erasmus+ Programm gefördertes Projekt mit Partnern aus Deutschland (DIAS GmbH), Frankreich (BrailleNet) und Schweden (Funka).

Das COMPARE-Projekt hat ein Wiki-basiertes Verzeichnis entwickelt, in dem Barrierefreiheits-Prüfer und Entwickler web content cases eintragen, bewerten und kommentieren können (http://compare.accessiweb.org/ ) . Die Bewertung folgt den Kriterien der Web Content Accessibility Guidelines (WCAG) und wird im Sommer 2019 um die neuen Kriterien der WCAG 2.1 erweitert. Der Vergleich der Bewertungen ermöglicht einen Austausch über die je nach Land und genutzter Evaluations-Methode oft unterschiedliche Bewertungspraxis.

Die im COMPARE-Verzeichnis eingetragenen web content cases werden aber nicht nur nach dem WCAG-Standard bewertet und kommentiert. Menschen mit Behinderungen nutzen die dokumentierten cases, die Ergebnisse der Usability-Test werden dokumentiert (z. B. in Screencasts)[1]. Die Resultate dieser Usability Tests werden den web content cases hinzugefügt und zeigen damit auch, inwieweit die abgegebenen Bewertungen der Barrierefreiheit nach WCAG die tatsächlichen Probleme, die Menschen mit Behinderungen bei der Nutzung haben, erfassen.

Ein zweiter Baustein des COMPARE-Projektes ist ein CONTAO-basiertes Informations- und Lernmodul, das die Anforderungen für wichtige interaktive Bausteine des Webdesigns beschreibt und praktische Probleme von Nutzern dokumentiert, z. B. über kommentierte Ausschnitte von Screencasts. Zudem wird auf öffentlich verfügbare Best-Practice-Beispiele für inklusives Webdesign und auf die web content cases des COMPARE-Verzeichnisses verwiesen.

Der Vortrag gibt einen Überblick über die Projektergebnisse, lädt zum aktiven Mitmachen beim Verzeichnis ein und öffnet einen Raum für Fragen und Anregungen.

[1] Diese Arbeit hat im März 2018 begonnen und wird sich bis Ende 2018 fortsetzen.